Unterschiedliche Regulatorien bezüglich guter Praxis (GLP, GMP, GCP, und andere) sowie auch die normativen und regulatorischen Dokumente (ISO, ICH, EMEA und FDA) sagen, dass alle Prozeduren innerhalb bestimmter Akzeptanzkriterien liegen müssen. Diese Anforderung beinhaltet, dass die Prozeduren validiert sein müssen. Es gibt verschiedene Dokumente, die definieren wie die zu testenden Validierungskriterien auszusehen haben. Allerdings beschreiben sie keinen experimentellen Ansatz und beschränken sich in der Regel auf allgemeine Konzepte. Deshalb haben sich die Mitglieder von SFSTP zusammengeschlossen und einen Konsens im Bereich der Validierungsrichtlinen geschaffen, um der Pharmaindustrie die Möglichkeit zu geben ihre analytischen Methoden zu validieren.

Dieser Ansatz erlaubt es das Risiko dass eine nicht ausreichend genau Methode angenommen wird - oder eine fähige Methode verworfen wird - zu minimieren.

Die Genauigkeits-Profil-Methode benutzt ISO-Terminologie und liefert eine experimentelle Strategie zur Validierung analytischer Methoden. Sie funktioniert unabhängig vom industriellen Sektor und nutzt die durchgeführten Experimente optimal um ein Maximum an Information aus den Ergebnissen zu erhalten. Gleichzeitig wird das Risiko für die Notwendigkeit von Re-Analysen der gleichen Proben minimiert.

Um das Ziel der Validierung zu spezifizieren muss man zunächst auf den Kern der Anwendung und die Natur der analytischen Methode zurück kommen. Ist es das Ziel zu zeigen, dass der Response eine lineare Funktion der Konzentration ist? Das heißt, dass der Fehler und die Präzision kleiner als x%. sind? Oder will man zeigen, dass unbekannte Mengen so genau wie möglich bestimmt werden kann? Diese Fragen sollten von zentralem Interesse sein. Eine gute analytische Methode ist in der Lage jede unbekannte Menge, die im Labor gemessen werden soll so genau wie möglich zu bestimmen. Mit anderen Worten: Der Analyst interessiert sich für den Unterschied zwischen dem gemessenem Wert \(x\) und dem wahren Wert \(\mu_T\). Letzterer ist immer unbekannt. Dennoch sollte der Unterschied zwischen beiden möglichst klein und innerhalb akzeptabler Grenzen sein. Man kann diese Anforderung zeigen, indem:

Die Akzeptanzgrenze \(\lambda\) kann je nach Anforderungen des Analysten oder nach Anwendungsbereich der analytischen Methode unterschiedlich sein. Die Akzeptanzgrenze ist typischerweise abhängig vom angedachten Anwendungsbereich der Methode (z.B. 1%-2% für die Analyse von pharmazeutischen Mischungen, 5% für die Bestimmung von aktiven Inhaltsstoffen in der Dosierung, 15% in der Bioanalytik, etc.)

Es ist also nicht nur wichtig, dass die Methode innerhalb der Akzeptanzgrenzen arbeitet, sondern auch, dass der Analyst die Akzeptanzgrenzen für die jeweilige Anwendung akzeptieren kann.

Auf der anderen Seite kann jede analytische Methode anhand von zwei Arten von Fehlern beschrieben werden:

Bias und Varianz der Methode können anhand der Daten, die zur Validierung erhoben werden, abgeschätzt werden. Die Verlässlichkeit dieser Schätzer hängt davon ab wie adäquat die Messungen waren, die an bekannten Proben durchgeführt wurden (Validierungs Standards SV). Sie hängt außerdem vom experimentellen Design und der Anzahl der durchgeführten Replikate ab. Basierend auf diesen Schätzern von Bias und Varianz, sowie den Akzeptanzgrenzen für die Performanz der Methode \(\lambda\) ist es möglich ein Konzept einer guten analytischen Methode for den jeweiligen Anwendungsbereich zu definieren.

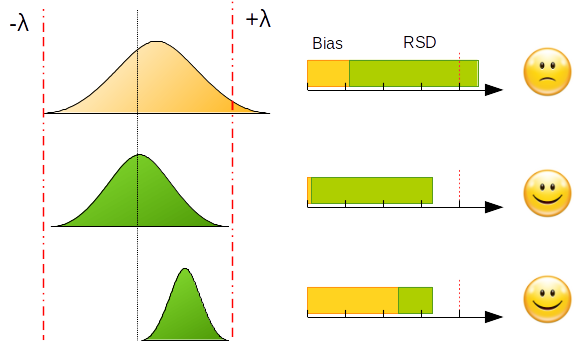

Das folgende Beispiel zeigt die Implementierung von Akzeptanzkriterien für „“unterschiedliche Werte von Bias und Präzision.

Der Versuch eine Methode ohne Bias und ohne Fehler zu entwickeln geht mit nicht unerheblichen Kosten einher. Dieses Ziel ist für einen Analysten mit limitierter Zeit unrealistisch. Selbst bei Verwendung von experimentellen Designs, die in der Literatur ausführlich beschrieben werden, ist es meist nicht möglich alle analytischen Parameter während der Entwicklungsphase zu optimieren.

Um diesem Dilemma zu entkommen muss der Analyst minimale Risiken eingehen (zumindest in dem Rahmen in dem es die Ziele der Analytik erlauben). Um dieses Risiko zu kontrollieren kann das Ziel sein, einen bestimmten, maximalen Anteil der Messungen außerhalb der Akzeptanzgrenzen zuzulassen. Möglicherweise ist es akzeptabel wenn 5% oder 20% der Messungen außerhalb der Akzeptanzgrenzen liegen. Dieser Anteil repräsentiert damit das maximale Risiko das der Analyst eingehen kann.

Eine Methode ist akzeptabel, wenn es sehr wahrscheinlich ist, d.h. garantiert werden kann, dass der Unterschied zwischen den Messungen \(x\) einer Probe und ihrem wahren Wert \(\mu_T\) innerhalb der gewählten Akzeptanzgrenzen liegt. Dieses Konzept kann folgendermaßen beschrieben werden:

\(\beta\) ist der Anteil der Messungen, die innerhalb der Akzeptanzgrenzen liegen. \(\lambda\) sind die Akzeptanzgrenzen, die schon vorher vom Analysten festgelegt wurden. Der erwartete Anteil an Messungen, die außerhalb der Akzeptanzgrenzen liegen stellt das Risiko der analytischen Methode dar.

Das Ziel der Validierung ist es sowohl dem Labor wie auch den Behörden zu garantieren dass jede Messung die später bei Routineauswertungen stattfindet nahe genug am unbekannten wahren Wert der Probe liegt. Zumindest jedoch ist garantiert, dass der Unterschied kleiner als die gewählten Akzeptanzgrenzen der Methode sind.

Ziel der Validierung ist es sowohl das Verbraucher- wie auch das Hersteller-Risiko zu minimieren. Folgerichtig kann sich die Validierung nicht allein auf die Berechnung des Bias und der Varianz einer Methode beschränken. Die Bewertung des Risikos erfordert mehr, allerdings sind Bias und Varianz eine notwendige Grundlage. Dazu müssen zwei Begrifflichkeiten erklärt werden. Nahe genug bedeutet, dass der unter realen Bedingungen erhobene Messwert weniger als \(x \%\) vom wahren Wert entfernt liegt. Garantiert heißt, dass jeder Messwert nahe genug am wahren Wert liegt.

Aus dieser Sicht sind Richtigkeit, Genauigkeit, Linearität … nicht mehr Statistiken die es erlauben diese Garantien zu quantifizieren. In der Praxis erwartet man von einer Methode, dass Sie in der Lage ist zu messen auch wenn Sie nicht präzise ist. Allerdings erhöht bessere Genauigkeit die Wahrscheinlichkeit des Erfolgs. Deshalb muss man trennen zwischen den Statistiken, die helfen eine Entscheidung zu treffen (eine Methode kann z.B. auf der Basis ihrer Eignung zu Quantifizieren als valide oder nicht valide akzeptiert werden) und denen die helfen eine Diagnose zu finden (z.B. statistische Tests, die die Genauigkeit eines Regressionsmodells oder die Homogenität der Varianzen beurteilen).

Man braucht angepasste Entscheidungswerkzeuge um Garantien geben zu können, dass zukünftige Messungen innerhalb der Akzeptanzgrenzen liegen. Wenn die Garantien, die eine Methode liefern kann nicht ausreichen, geben diagnostische Werkzeuge einen Anhaltspunkt wo das Problem zu suchen ist. Das ist natürlich nur notwendig, wenn die Garantien nicht ausreichen.

Die meisten in der Praxis angewandten Entscheidungsregeln basieren auf der folgenden Nullhypothese.

wobei gilt: \(\text{bias} = x-\mu_T\) , der \(\text{relative bias} = \frac{x - \mu_T }{\mu_T} \cdot 100\) und die \(\text{recovery} = \frac{ x}{\mu_T} \cdot 100\)

Auf diese Weise wird eine Prozedur fälschlicherweise als angemessen eingestuft, wenn das 95%.-Konfidenzintervall des mittleren Bias den Wert 0 enthält (bzw. 0%. oder 100%. in Bezug auf den relativen Bias oder die Recovery). In einem Validierungs-Kontext ist die Anwendung des Tests jedoch falsch. Hierbei wird nicht der Anwendungsbereich des Methode für die Akzeptanzgrenzen berücksichtigt. Ferner gibt es zwei Arten wie eine Methode fälschlicherweise validiert werden könnte: Entweder wenn die Standabweichung groß ist (geringe Präzision, aber kein Bias) oder bein einer zu geringen Anzahl Wiederholungen.

Arbeitet man statt dessen mit Akzeptanzgrenzen \(\pm \lambda\) umgeht man diese Probleme: Man vermeidet es Methoden mit hoher Präzision und niedrigem Bias zu verwerfen oder Methoden mit geringer Präzision und hohem Bias anzunehmen. Das Akzeptanzkriterium ist ein Kompromiss zwischen Bias und Variabilität, so dass ein bestimmter Anteil der Messungen innerhalb der Spannweite \(\pm \lambda\) liegen wird.

Diese Entscheidungsregel ist sinnvoller, als die vorangegangene. Sie akzeptiert alle Methoden mit einer geringen Streuung, während Methoden mit hoher Ungenauigkeit verworfen werden. Ferner wird eine Methode, die einen Bias aufweist nur akzeptiert, wenn sie eine hohe Präzision hat. Im Umkehrschluss muss eine Methode mit geringer Präzision einen geringen Bias aufweisen um akzeptiert zu werden.

Dennoch ist die Verwendung von Nullhypothesen, wie z.B. ein Test für den Achsenabschnitt, Gleichheit der Steigungen oder ein Lack-of-Fit-Test in vielen Bereichen weiterhin üblich. Bei all diesen statistischen Tests haben Verfahren mit einer geringen Präzision eine erhöhte Wahrscheinlichkeit akzeptiert zu werden. Das ist allerdings nicht was wir von einem Analysten bei der Bewertung einer Methode erwarten würden.

Hier ist die Entscheidungsregel einfach, sichtbar und konsistent das Verwenden des Genauigkeitsprofils zusammen mit den relativen Akzeptanzgrenzen \(\pm \lambda\).

Das Genauigkeitsprofil wird aus dem Konfidenzintervall der erwarteten Messwerte ermittelt und ermöglicht die Einschätzung eines analytischen Verfahren im Hinblick auf seine Fähigkeit Messwerte innerhalb der Akzeptanzgrenzen zu liefern. Das Genauigkeitsprofil beschreibt den Bereich, in dem ein Verfahren Messergebnisse mit bekannter Genauigkeit und einem vom Anwender vorgegebenen a priori Risiko, liefert. Nimmt man z.B. ein Risiko von 5% an, ist man in der Lage mit 95%iger Wahrscheinlichkeit zu garantieren, das zukünftige Messwerte innerhalb der Akzeptanzgrenzen liegen. Der Prozentsatz von durch die regulatorischen Anforderungen definiert (z.B. 1% oder 2% für Massenware, 5% für pharmazeutische Spezialprodukte, 15% für Bioassays, usw. ).Das Profil wird mit den Schätzern für Bias und Präzision des analytischen Verfahrens bei jeder Konzentrationsstufe am Ende der Validierungsphase ermittelt. Dieses Konfidenzintervall ist das sogenannte \(\beta\) -erwartete Toleranz Intervall . Es definiert ein Intervall in welches ein erwarteter Anteil zukünftiger Messergebnisse fallen wird. Dieses Toleranzintervall hat folgende Eigenschaften:

wobei E die Erwartung eines Ergebnisses ist.

Die Berechnung des erwarteten \(\beta\) -Toleranzintervalls erfordert Schätzungen für den Bias und die Standardabweichung der vorläufigen Präzision des Verfahrens, die notiert wird als \(\mu_M\) und \(\ sigma_M\).

Das Genauigkeitsprofil kann leicht erzeugt werden, indem man die unteren und die oberen Grenzen des Toleranzintervalls verbindet. Sollte das Toleranzintervall breiter sein als die Akzeptanzgrenzen, müssen neue Grenzen für die Quantifizierung sowie neue Intervalle für die Dosierungen definiert werden: die obere Quantifizierungsgrenze (ULQ) und die untere Quantifizierungsgrenze (LLQ). Letztere trifft genau die Definition unseres Kriteriums, d.h. die kleinste Substanzmenge die mit ausreichender Genauigkeit und Präzision ermittelt werden kann.

Wie man sehen kann, ermöglicht die Verwendung des Genauigkeitsprofil als Entscheidungswerkzeug nicht nur die Ziele des Verfahrens mit denen der Validierung in Übereinstimmung zu bringen, sondern auch die Fähigkeit des Analyseverfahrens für den jeweiligen Anwendungsfall visuell zu erfassen.

Das analytische Verfahren bezieht sich auf die Art und Weise der Durchführung der Analyse. Es sollten die notwendigen Schritte zur „“Durchführung jedes analytischen Tests im Detail beschreiben. Dies können unter anderem sein: die Sticprobe, der Referenz-Standard und Reagenzien, Vorbereitungen, Verwendung einer Vorrichtung, Generierung der Eichkurve, Verwendung von Formeln für die Berechnung, etc.. (dies ist keine vollständige Liste)

Spezifität ist die Fähigkeit, den Analyten im Beisein von anderen erwarteten Komponenten eindeutig zu bestimmen. In der Regel könnte dazu gehören Verunreinigungen, Abbauprodukte, Matrix, etc.. Mangelnde Spezifität eines einzelnen analytischen Verfahrens kann durch andere unterstützende analytische Prozeduren kompensiert werden.

DIe Genauigkeit eines analytischen Verfahrens ist ein Ausdruck der Übereinstimmung zwischen dem Ermittlungsergebnis und dem wahren Wert bzw. dem Referenz Wert. Dies wird korekt als Richtigkeit bezeichnet.

Die Präzision eines analytischen Verfahrens wird als Streuung (Maß der Abweichungen) zwischen einer Reihe von Messergebnissen, die unter Wiederholbedingungen gemessen wurden. Präzision kommt in drei verschiedenen Formen vor: Wiederholbarkeit, Zwischenpräzision und Reproduzierbarkeit.

Die Nachweisgrenze eines analytischen Verfahrens ist die niedrigste Menge des Analyten in einer Probe die erkannt aber nicht unbedingt mit einem exakten Wert quantifiziert werden kann.

Die Quantifizierungsgrenze eines analytischen Verfahrens ist der niedrigste Wert des Analyten in einer Probe, der quantitativ mit ausreichender Präzision und Genauigkeit ermittelt werden kann. Die Quantifizierungsgrenze ist ein Parameter der quantitativen Assays für kleine Mengen von Substanzen in einer Probe und dient oft zur Bestimmung von Verunreinigungen und/oder Abbauprodukten.

Die Linearität eines analytischen Verfahrens ist seine Fähigkeit (innerhalb eines gegebenen Bereichs), Testergebnisse direkt proportional zur Konzentration des Analyten in einer Probe (Menge) zu ermitteln.

Die Spannweite eines analytischen Verfahrens ist der Abstand zwischen der oberen und unteren Konzentration (Mengen) die der Analyt in der Probe hat, bei der nachgewiesen wurde, dass das analytische Verfahren eine ausreichende Präzision, Genauigkeit und Linearität hat.

Die Robustheit eines analytischen Verfahrens ist ein Maß für seine Fähigkeit, durch kleine, aber gezielte Veränderungen von Methodenparametern, bei normaler Nutzung unverändert zuverlässig zu sein.